- 資源

淺白用語摘要 (Plain Language Summaries,PLS) (給一般人士閱讀的摘要) 的重要性不斷升高,在拓展臨床研究範疇以及增進大眾對研究團體的信心上,已然是非常重要的一個溝通工具。淺白用語摘要是以非科學且簡單易懂的語言,為臨床試驗志願參加者摘要總結試驗的結果,此外也可為非醫療專業的人士,就有關研究結果、疾病與治療方法提供值得信賴的可靠資訊。

根據歐盟 (EU) 的臨床試驗規範 (CTR No 536/2014),提供並公開揭露供一般人士閱讀的摘要現在已是法規要求的必要措施。這會是生成式 AI 與生命科學的一個新應用機會嗎?我們能否運用 AI 內容創作來協助製作這類摘要,進而減輕臨床試驗報告方面的負擔?PLS 通常是由醫療寫作專業人員和/或資訊公開專家負責撰寫,在歐盟內也必須遵守嚴格的法規時程限制。此外,由於這類報告涉及揭露敏感的研究結果,而且發佈時藥品或治療性介入措施往往還未取得應用於臨床實務的核可,因此這些報告的製作也深具挑戰性。

在這篇部落格文章中,我們將探索 AI 與臨床試驗這個深具潛力的新應用:在不犧牲科學正確性的前提下,我們是否能運用 AI 內容工具來輔助淺白用語摘要的撰寫與翻譯?

從科學用語到淺白用語

以淺白用語撰寫高品質且難易度適中的臨床結果摘要其實並不容易,它所需投入的心力與具備的技巧也經常遭到人們所低估。這是個跨領域的工作,除了需要具備語言、溝通和視覺設計方面的技巧,也必須擁有以下領域的專業知識:

- 臨床試驗研究方法

- 法規要求

- 生物醫學統計學

- 健康識讀原則

值得注意的是,臨床研究結果的摘要也很容易招致風險,包括:

- 挑選要納入簡短摘要中的計畫書評估指標時,可能無意間會有偏見

- 錯誤地陳述試驗結果,進而危害到試驗的科學誠信度

- 在風格和語氣上的不當轉變,例如導入宣傳性的語言或是毫無事實根據的功效聲明

- 在翻譯摘要時維持語言風格、術語和正確性

- 未能顧及健康識讀和數值識讀原則,因而無法確保摘要對非科學界的目標對象來說通順易讀

有鑑於摘要及公開揭露臨床研究結果的諸多風險,很多試驗委託者對於在其 PLS 開發中部署 AI 都感到憂心忡忡。委託者若是缺乏必要的跨領域專業能力,不但無法妥善地為 AI 部署定義使用案例,亦難以在 AI 與人類參與間找到適當的平衡點。

臨床試驗的 AI 應用有哪些潛在利益?

如果能擬定適當的使用案例,AI 可望大幅減輕總結與草擬淺白用語摘要的工作負荷。在臨床試驗中使用 AI,並不代表人力資源可能會因此被取代。根據歐盟人工智慧法 (EU AI Act) 的規定,AI 系統的部署單位必須指派擁有必備能力、訓練和職權的個人,擔任人類監督的工作。人類必須根據以下事項,定義脈絡並驗證 AI 的輸出:

- 臨床研究專有的知識

- 文化細微差異

- PLS 語氣

此外,過度依賴臨床試驗中的 AI 其實也很危險,因為不正確的摘要可能會造成嚴重的傷害或不信任感。

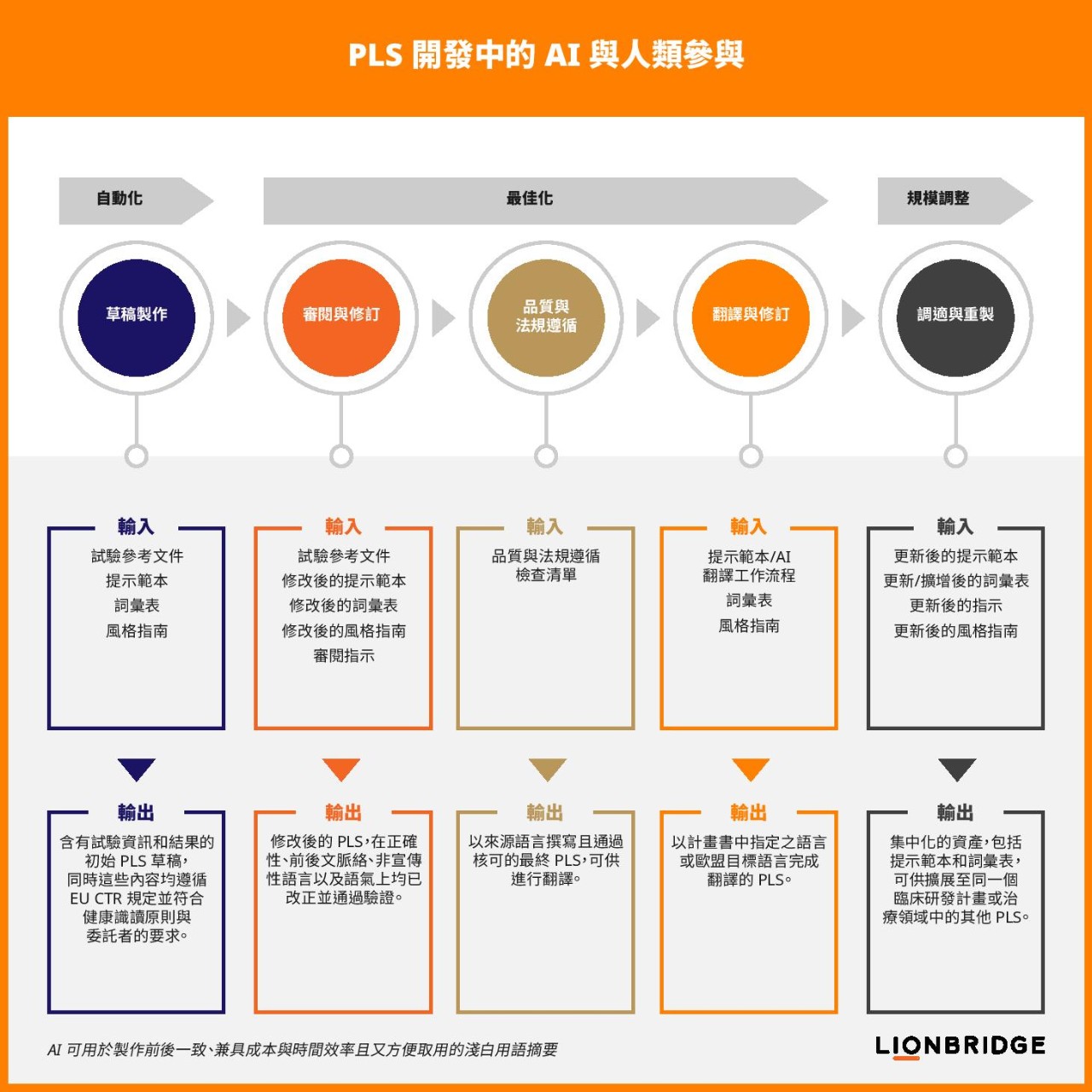

有鑑於 PLS 溝通在敏感性和語言上所面臨的眾多挑戰,Lionbridge 建議可運用 AI 將 PLS 草稿製作的初始階段自動化。在這之後,亦可使用 AI 來最佳化摘要製作的其他階段:

- 修訂

- 精進

- 翻譯

試驗委託者可以運用卓越的提示工程能力,來自動生成 PLS 初稿。他們可以下指令給大型語言模型 (LLM),要它從臨床試驗報告和其他相關的參考資料 (例如臨床試驗計畫書、知情同意書或知情同意表、列表、圖表等) 中,擷取並摘要已預先定義的資訊。但是品質不佳的提示,生成的回答自然也不理想,這又會加重 PLS 撰寫的負荷。為了避免發生這種情形,應該要請工程專家設計提示工程來防範以下狀況:

- LLM 幻覺

- 內文脈絡的長度限制

- 陳述錯誤訊息

從範本開始著手

Lionbridge 設計了一個符合 EU CTR 附件 V 之內容要求以及健康識讀原則的提示主範本,可以用來將 PLS 初稿的製作加以自動化。提示範本可以讓試驗委託者取得健全的 PLS 初稿,也就是含有正確資訊並以淺白用語撰寫的初稿。此外,委託者也可以依據他們的臨床試驗報告和範本來調整提示範本,告訴 LLM 哪裡可以找到正確的資訊。由於臨床試驗報告動輒數百或數千頁,因此審慎的提示工程可以幫醫療寫作人員和試驗團隊節省大量的時間,使他們得以將心力專注在正確地詮釋技術細節與微調精進摘要內容。

生成出 PLS 初稿並進入審閱與修訂的階段後,提示工程迭代會變得更加複雜,因而必須要預先定義好工作流程來推動效率並充分最佳化 PLS 開發。除了初稿階段,LLM 亦可應用於後續流程,用以精進內容、語言和 PLS 可讀性。此外,亦可使用 AI 和人工譯後編修來最佳化自然語言翻譯。

委託者可以從 PLS 提示工程主範本開始著手,根據以下事項調整這個範本:

- 不同的試驗階段

- 試驗人口族群

- 治療領域

- 臨床試驗特有的其他部分

此外,只要是隸屬於同一個臨床研發計畫之下,也可以調整主提示以重複使用於不同的臨床試驗。至於 AI 在 PLS 中的涉入程度,則取決於 PLS 開發的相關風險以及委託者的風險忍受度。

在 PLS 開發期間避免偏見、疏漏或扭曲意思

偏見是研究摘要的一個已知風險,也是試驗委託者在開發淺白用語摘要時必須設法降低的一個風險。值得注意的是,在選擇要納入摘要中的評估指標時,這個問題更顯得重要。第 3 或第 4 階段的計畫書可能會納入主要評估指標、次要評估指標和第三評估指標,委託者可以決定哪些評估指標跟病人相關而應加入 PLS。「優良淺白摘要實務」(Good Lay Summary Practice,GLSP) 這個指引則建議委託者,最好根據已制訂且記錄完善的評估指標挑選架構,預先定義所要加入的評估指標。在為 PLS 選擇評估指標時,這麼做會有助於避免發生偏見風險。試驗委託者也可以將這些預先挑選的評估指標加入 PLS 提示範本中,確保 LLM 能呈現並擷取到正確的結果。

在 PLS 開發流程中,當 LLM 依照指示總結常見的不良事件或病人臨床試驗招募的納入和排除條件時,也可能會發生偏見、疏漏或陳述失實的問題。如果沒有更進階的提示以及人類監督,LLM 可能會遺漏一些對病人而言很重要的不良事件,或甚至因為缺乏前後脈絡而錯誤地詮釋某些安全性資料;又或者,它也可能會遺漏一些重要的資格條件,而去摘要總結那些對試驗而言相關程度較低的條件。試驗團隊及醫療寫作人員應該要確保 PLS 能:

- 處理與顧及病人利益

- 陳述有利跟不利的結果

- 與細微的科學差異一致

為不同臨床開發方案進行準備、精進與擴大規模

技巧精湛的提示工程師能夠製作與精進提示範本、將提示的再利用自動化,或是執行提示後處理作業,進而打造出最合適的工作流程。事先投入心力開發與測試提示主範本,委託者便能提升自動生成之 PLS 草稿的品質。視試驗委託者使用的方法而定,PLS 可能需要數次的提示迭代。提示範本也可在臨床開發方案中的不同研究間重複使用與調整設定。隨著 AI 的發展以及不同自然語言之語料庫的改善,從用來源語言草擬 PLS 一直到將其翻譯至目標語言,這整個流程也可能會進一步簡化。

LLM 是使用龐大的語料資料集進行訓練,因此若想生成所需的 PLS 輸出,就必須運用卓越的提示工程能力來進行微調精進。試驗委託者應謹記,提示是人製作的,因此可能會含有偏見,這些偏見又會被 LLM 放大或重現。衍生自 AI 與臨床試驗的這些偏見 (無論是有意還是無意),都可能導致意義遭到曲解或是偏頗的結果摘要。

與我們聯絡

負責任的 AI 使用,是指公開透明的 AI 使用。根據歐盟人工智慧法,若使用 AI 生成或運用文字並供大眾取用,則部署 AI 與臨床試驗的實體必須揭露此項事實。因此,試驗委託者必須清楚指明他們在 PLS 流程中的哪些地方以何種方式應用 LLM。

Lionbridge 開發的 TRUST 架構,旨在培養人們對我們 AI 使用的信心,並確保研究團體、客戶及大眾對 AI 的信任。如需更多有關 AI 與臨床試驗的資訊,歡迎閱讀我們的電子書《AI 及語言策略在生命科學中的應用》,了解更多深入見解。歡迎與我們聯絡。